| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- MinHeap

- Reinforcement Learning

- machine learning

- BFS

- dfs

- Mask Processing

- eecs 498

- NLP

- AlexNet

- DP

- YoLO

- 그래프 이론

- 강화학습

- ubuntu

- MySQL

- 머신러닝

- 백준

- opencv

- One-Stage Detector

- dynamic programming

- two-stage detector

- CNN

- C++

- Python

- deep learning

- LSTM

- r-cnn

- image processing

- real-time object detection

- 딥러닝

- Today

- Total

목록딥러닝 (36)

JINWOOJUNG

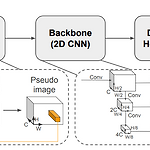

PointPillars: Fast Encoders for Object Detection from Point Clouds

PointPillars: Fast Encoders for Object Detection from Point Clouds

PapaerPointPillars Introduction 자율주행차는 차량, 보행자, Cyclist와 같은 동적 객체를 검출해야한다. LiDAR 3D PointCloud Data(PCD)를 기반으로 한 Object Detection Task는 Bottom-up Pipeline을 통해 연구되어왔다. 즉, Hand-crafted Feature를 기반으로 지면 제거 후 객체에 대한 Clustering, Classification이 진행된다. 단순히 Hand-crafted Feature만으론 한계가 있기 때문에 Computer Vision 분야의 Deep Learning Methods가 도입되면서 PCD에 적용하려고 했지만, Sparse하고 3D 구조인 PCD의 특성 상 2D Image에 적용되는 Convol..

[EECS 498] Lecture 17: Attention

[EECS 498] Lecture 17: Attention

본 포스팅은 Michigan Univ.의 EECS 498 강의를 수강하면서 공부한 내용을 정리하는 포스팅입니다.https://jinwoo-jung.tistory.com/147 [EECS 498] Lecture 16: Recurrent Neural Networks본 포스팅은 Michigan Univ.의 EECS 498 강의를 수강하면서 공부한 내용을 정리하는 포스팅입니다.Introduction 기존까지의 Neural Networks를 활용한 Task는 Image 기반의 Calssification, Detection, Segmentation이 주를jinwoo-jung.comIntroduction지난시간에 학습한 Seq2Seq를 자세히 살펴보자. Seq2Seq는 Machine Translation Task에 ..

[EECS 498] Lecture 16: Recurrent Neural Networks

[EECS 498] Lecture 16: Recurrent Neural Networks

본 포스팅은 Michigan Univ.의 EECS 498 강의를 수강하면서 공부한 내용을 정리하는 포스팅입니다.Introduction 기존까지의 Neural Networks를 활용한 Task는 Image 기반의 Calssification, Detection, Segmentation이 주를 이뤘다. 이러한 Feedforward Neural Network는 1개의 Image를 Input으로 하여, 해당 Image의 Class, Localization 정보 등 1개의 Output을 반환하는 구조이다. 앞으로 살펴볼 Recurrent Neural Network(RNN)은 시계열 혹은 순차 데이터를 처리하고 예측하는 딥러닝을 위한 신경망 구조이다. RNN은 기존의 one to one 구조가 아닌 여러 구조에..

VoxelNet: End-to-End Learning for Point Cloud Based 3D Object Detection

VoxelNet: End-to-End Learning for Point Cloud Based 3D Object Detection

PapaerVoxelNet AbstractSparse한 LiDAR PCD를 Region Proposal Network(RPN)과 연결하는 연구는 Hand-crafted Feature를 기반으로 연구되었다. 본 논문에서는 Feature Extraction과 Bounding Box Prediction을 하나의 Stage로 통합하여 E2E 학습이 가능한 Deep Network인 VexelNet을 제안한다. VoxelNet은 Point Cloud를 동일한 크기의 3D Voxel로 나눈 뒤, 각 Voxel 내 Point를 Voxel Feature Encoding(VFE) Layer를 통해 통합된 특징으로 표현한 결과를 RPN으로 전달하는 구조이다. VoxelNet은 LiDAR Data만 활용하여 Car, Ped..

PointNet: Deep Learning on Point Sets for 3D Classification and Segmentation

PointNet: Deep Learning on Point Sets for 3D Classification and Segmentation

PaperPointNetIntroduction 기존 Deep Learning 연구에서의 CNN은 Regular Input Data를 기반으로 동작한다(Image, Voxel, etc). 하지만, Point Cloud는 순서가 없는(Inordered) Inrregular Data이다. 따라서 Raw Point Cloud Data(PCD)를 CNN의 Input으로 취하는 것은 한계가 있다. 전처리 과정에서 PCD를 Regular Form(3D Voxel Grid, Collections of Images, etc)으로 변환하는 과정은 불필요한 메모리 및 계산 시간 증가를 초래하며, Quantization Artifacts에 의한 원본 정보 왜곡 및 Natural Invariances이 깨질 수 있다. Qua..

보호되어 있는 글입니다.

SSD: Single Shot MultiBox Detector

SSD: Single Shot MultiBox Detector

Research Paper SSD Abstract 본 논문에서는 A Single Deep Neural Network인 Single Shot MultiBox Detector(SSD)를 제안한다. SSD는 서로다른 해상도를 가지는 Feature Maps에 대하여 서로다른 크기와 비율을 가진 Default Boxes로 객체를 예측 한다. SSD는 One-Stage Detector로써 빠른 속도를 가짐과 동시에 높은 mAP를 달성하였다. 특히 다양한 해상도를 가지는 Feature Maps에 대하여 예측함으로써 작은 크기의 객체에 대한 정확도를 향상시킨다. Introduction Two-stage Detector는 추가적인 Region Proposal 생성 단계가 요구되기 때문에 정확하지만, 실시간 검출을 하기..

You Only Look Once: Unified, Real-Time Object Detection(YOLO)

You Only Look Once: Unified, Real-Time Object Detection(YOLO)

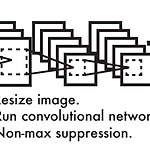

Research PaperYOLO AbstractYOLO는 Object Detection Task의 새로운 접근 방식이다. Object Detection Task를 하나의 Regression Problem으로 정의하며, 하나의 Network로 구현되어 End-to-End 최적화가 가능하다. One-stage Detector인 YOLO는 45fps의 실시간성을 보인다. YOLO는 더 많은 Loclization Error를 보이지만, 배경에 대한 FP를 줄이며, 객체에 대한 일반적인 특징을 잘 학습한다. Introduction Object Detection Task에서 좋은 성능을 보이는 Model은 Classifier를 Detection으로 변형한 구조를 가진다. 특히, R-CNN의 경우 Region Pr..